前言

假设公司对客户发起产品调研,而你需要分析问卷,找出待改进之处。例如:价格过高、售后支持不足或产品体验不佳。如果问卷较少,可以人工阅读,或一次性交由大模型分析。但面对上万份问卷时,这些方法便不再适用。使用大模型服务的 API 可以有效解决这个问题。本章将介绍如何使用大模型服务的 API 自动处理批量任务。

课程目标

学完本课程后,你将能够:

- 了解如何借助大模型服务的 API 来自动地处理一批任务

- 思考和发现你的业务可以借助大模型提效的机会

1 借助通义千问 API 自动完成一批文本处理任务

需求介绍:产品需要对客户发起一次产品调研,你的任务是统计出用户认为产品哪些方面有待改进,比如:价格过高、售后支持不足、产品使用体验不佳等。

现状:收集到1万多份主观反馈,并未结构化。

难点:要求在1天内做出分析。

在这样的情况下,借助大模型服务的 API 可以大大简化和加速文本处理的任务。你可以通过一段简单的代码来解决这一问题:

from langchain_community.llms import Tongyi

# 创建一个Tongyi类的实例,使用模型 'qwen-max',你也可以将使用其他模型,比如将 qwen-max 替换为 qwen2-72b-instruct

llm = Tongyi(model_name='qwen-max')

# 使用实例的方法 invoke 调用模型服务,传入提示词

result = llm.invoke("""你需要对用户的反馈进行原因分类。

分类包括:价格过高、售后支持不足、产品使用体验不佳、其他。

回答格式为:分类结果:xx。

用户的问题是:性价比不高,我觉得不值这个价钱。""")

print(result)需要注意的是,运行这段代码前,需要先开通阿里云大模型服务平台百炼,然后在百炼上获取API Key 用于调用通义千问 API,最后将API Key配置到环境变量。

为了便于缺少代码基础的读者理解,这里我们使用了 langchain 框架来减少代码量,所以运行代码前你也需要安装依赖: pip install langchain_community dashscope。

如果希望使用其他模型,你可以替换代码中的 qwen-max 值,更多 model_name 的取值可以参考百炼的模型调用。

为了能够处理一批反馈,你可以考虑调整一下代码,从 Excel 文件中读取反馈并进行分类,最后代码会类似这样:

import os

from openpyxl import load_workbook

from langchain_community.llms import Tongyi

llm = Tongyi(model_name='qwen-max')

# Excel文件路径

file_path_feedback = 'data/file_path_feedback.xlsx'

wb = load_workbook(file_path_feedback)

sheet = wb.active

for row in sheet.iter_rows(values_only=True, min_row=2):

feedback = row[0]

result = llm.invoke(f"""你需要对用户的反馈进行原因分类。

分类包括:价格过高、售后支持不足、产品使用体验不佳、其他。

回答格式为:分类结果:xx。

用户的问题是:{feedback}""")

print(feedback,result)上面的代码从路径为 data/file_path_feedback.xlsx 的 Excel 文件中逐行读取了用户的反馈,然后借助通义千问 API 得到分析结果,最终打印了出来。

如果你没有编程基础,不知道如何编写代码来实现需求,没有关系,可以召唤通义灵码来帮忙。通过自然语言描述,通义灵码能够将需求转化为代码。下面我们来演示流程。

- 为了简化流程,可以使用阿里云函数计算FC来调用通义灵码。你可以通过我们准备好的模板来创建一个函数计算应用作为环境,函数计算控制台上的在线 IDE 集成了通义灵码插件,你可以基于该环境来快速体验通义灵码的能力。

- 如果你想在本地编程环境运行通义灵码,可以参考下载通义灵码

- 首先请点击模板,然后参考下图选择【直接部署】,然后点击【创建并部署环境】。

- 待环境创建完成后,单击函数进入编程环境。

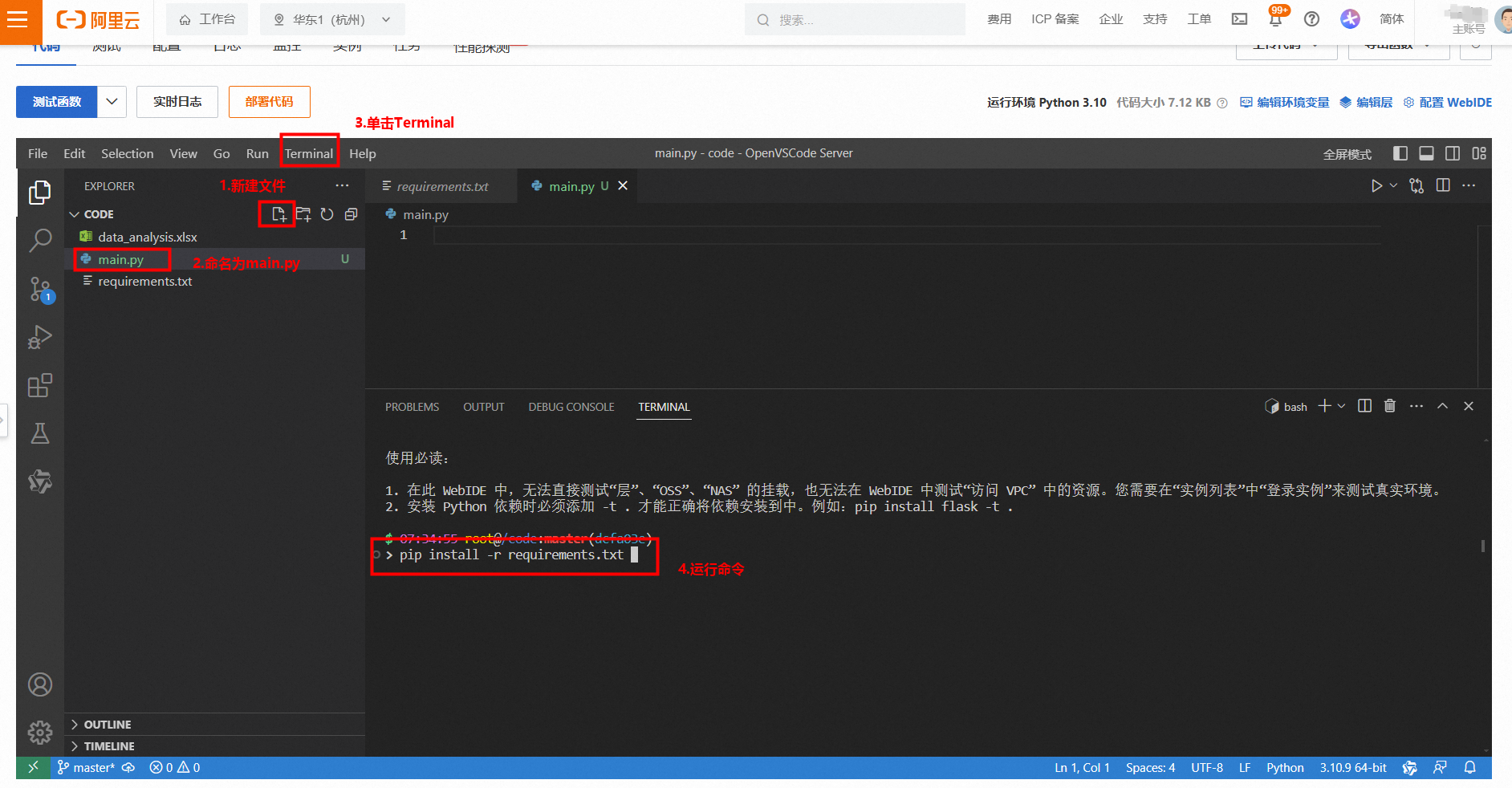

- 进入代码编辑器界面后,可以新建 main.py 文件。然后点击顶部的【Terminal > New Terminal】,并在命令行中输入 pip install -r requirements.txt 来安装相关依赖。

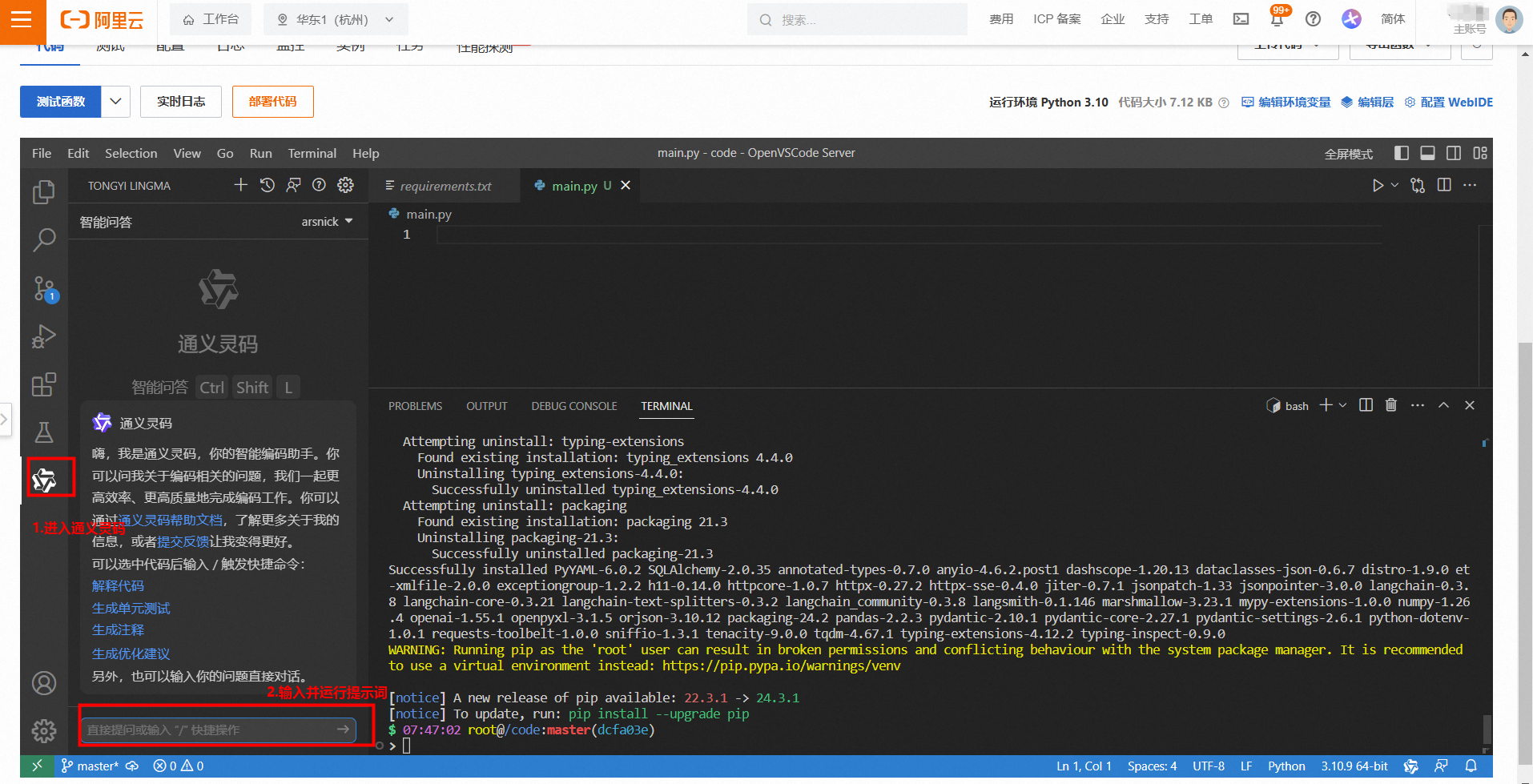

- 接下来,你就可以使用通义灵码组件,输入提示词。

由于训练数据时效性,通义灵码可能无法准确知晓最新的API,可以给到通义灵码一些代码参考,往往可以更好地达成目标。

参考代码来自:首次调用通义千问API,记得替换API-Key。

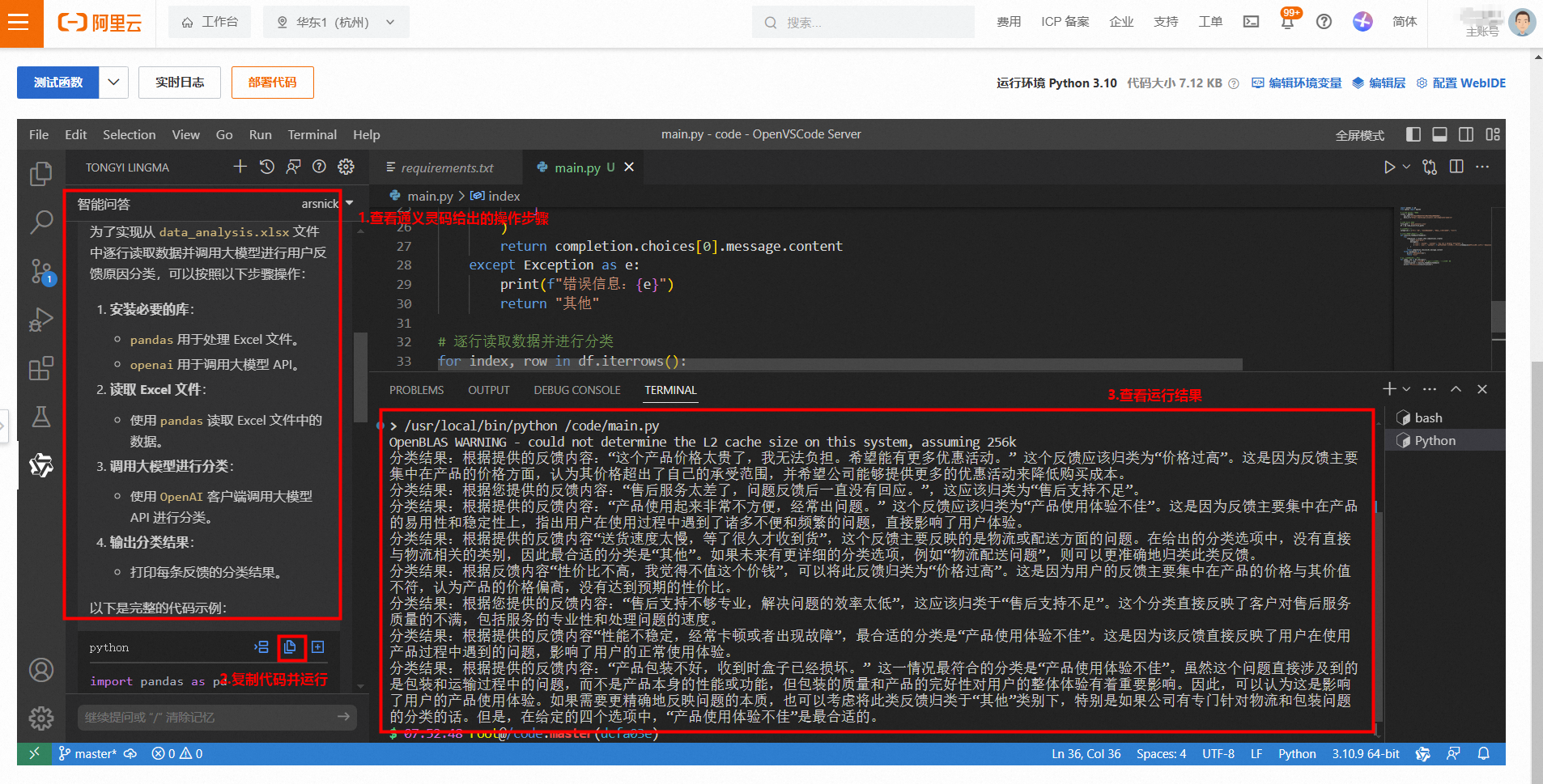

- 通义灵码写好代码后,你可以将代码内容复制到 main.py 文件中。 然后记得将 api_key="sk-xxxx" 中的 sk-xxx 替换为你自己的 API Key。最后就可以在命令行中执行 python main.py 运行通义灵码输出的代码,查看运行结果。

通义灵码输出的代码可能不会一次性有效,这时候可以调整提示词,多尝试几次。

通过本小节的内容,想必你已经了解如何调用通义千问API处理文本任务,哪怕你对编程知之甚少,也可以借助通义灵码来帮助你达成目标。

如果你所在的团队有专业的技术人员,那么在了解了大模型服务的API能力后,你也可以直接向技术人员提出需求以及建议实现方法,这能让技术人员更快地帮你编写代码并运行程序解决这些问题。

如果你仍然希望掌握如何运行这些代码,这里有一份入门级大模型服务的 API 教程或许能帮助到你。

2 阿里云上大模型服务的 API 调用

- 阿里云上提供了按量付费、开箱即用、多种参数规模的通义千问、开源大模型服务的 API。在满足业务需求的前提下,模型的参数规模越小,其API调用速度更快、成本更优。而参数规模越大,则能够应对更多复杂的业务场景。 更多细节内容可以参考模型调用。

- 你可以通过 通义千问-VL 视觉理解的能力实现拍照改作业之类的应用。

[进度: 已完成]本节小结

本小节通过一个案例为你介绍了如何在代码中集成大模型服务的 API 实现复杂的业务场景,帮助你更好理解使用程序来调用大模型的能力。

除了批量的文本处理任务外,也可以和其他算法模型结合起来使用处理更复杂的任务,比如可以使用声音转文字类的模型将客服电话记录转成文字,再借助大语言模型实现客服质检。

你也可以充分发挥想象力,在你的业务中找到可以和大模型结合的契机,实现系统的智能化,提升组织的工作效率。

发表评论 取消回复